如何消除AI应用程序?寻找更深的破布和数据库很

栏目:公司资讯 发布时间:2025-05-25 11:55

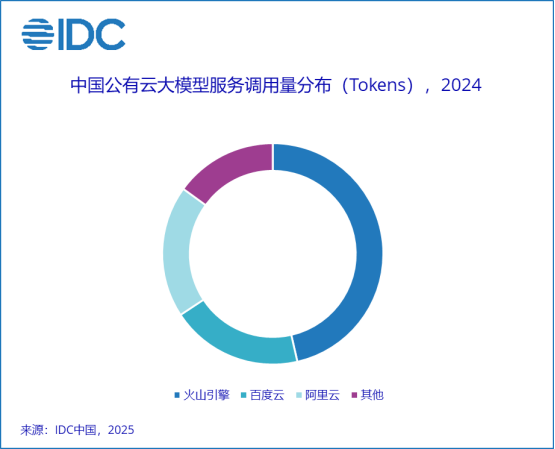

从2025年开始,AI模型的容量仍在迅速提高。注意这一领域表明,许多企业家花费了大量的精力创建AI应用程序,但是通常会迅速被新一代最大模型的“本地特征”取代。这种类型的应用程序被归类为快速软件包层(提示单词)。这些应用程序调用了大型模型的基本功能,该功能迅速设计单词,但不会创造更深的商业价值。很容易替换一个始终更强的大型模型,因为应用程序的值主要取决于最大模型的原始功能。如何开发不容易被大型模型“移动”的AI应用程序?从这个意义上讲,英特尔的技术专家认为,大型模型应用程序的开发可以轻松地作为大型模型的功能,因为它们需要基于大型模型的代理的直接开发,而不仅要扩展大型模型的功能。大型模型应用程序的开发必须从不好或无法克服大型模型的点开始,例如解决数据库问题。当前大型模型中,两个最明显的问题与数据有关。忍受的第一件事是幻觉。大型模型基本上执行随机操作。它发生的内容越多,概率偏差就越大。此外,数据质量培训可能导致幻觉。需要进行基本的技术变革,以完全消除短期幻想的问题。其次,我们无法实时更新我们对出色模型的知识。大型模型的前游泳大约几个月前有固定的时间,他不知道发生了什么,他无法按时更新他的知识基础。所做的答案仅基于已知的旧内容。为了应对这两个主要问题,该行业是要达成共识并建立抹布 - 底座D知识库(搜索改进)。根据大型且先前训练的模型连接外部数据源。所有任务和答案都是从知识库中提取的,然后最大的模型响应。在某些操作中,公司必须将内部文档转换为机器格式。该文档首先进行分割,然后对矢量进行分割,并最终保存在矢量数据库中。当用户调用问题时,问题将变成矢量,具体取决于它们,并在矢量数据库中寻求,并根据最终恢复的内容生成答案。在生成答案时,记忆和精度是概念重要的ICA。在内存中,让我们看看他们恢复了多少个“真正相关”的文档。精确度的是,寻求的文件数量“真的很重要”。英特尔专家说,在查看这些技术细节时,应该指出的是,大型模型的影响受到太多因素和链接的影响。例如,选择一个i将文本转换为文档大小,恢复数据等的媒介,段等的NTEGRY模型会影响最终一代的结果。在英特尔的专家意见中,制作出色的模型开发可能不是直接从代理商开始的最喜欢的方法。基于小数据的差异可能会恶化最终效果。换句话说,如果您可以处理数据本身,则它变得更加不可替代,而不是仅依赖于最大模型的性能。立即开始并创建云中业务层面的无效开发环境。如今,许多大型国家和外国公司都基于大型语言模型和破布技术建立业务知识,许多前线员工得到了高度认可。由于RAG的知识库对公司非常重要,因此火山引擎已经推出了云的镜子,以接纳RAG场景。火山引擎在模型服务的大领域非常有效。根据启动IDC“对中国公共云模型模型模型的结构,报告1T25”,火山发动机在2024年首次在呼叫市场中首次分类。火山发动机是火山弧是一种火山弧,只有大型模型服务平台,例如Cozeesarials De Hyagent。新推出的抹布镜使常规开发人员可以轻松地开发具有较大阈值模型的“联合限制”应用程序。抹布图像不仅包含集成的模块,还包括向量数据库,重读模型和7B DeepSeek蒸馏模型。它提供数据包皮,模块和前端页面来处理在线问答服务,并且所有软件电池均已预先优化。作为面向公司的服务,火山引擎的抹布图像是指OPEA Architecture。 OPEA是去年Intel推出的开源社区,使用开放式体系结构和模块化组件来帮助公司构建可扩展的AI应用程序NS实施基础。与普通的开源体系结构相比,火山发动机图像具有更多的业务水平。许多云制造商还为普通用户提供较低阈值的抹布服务,但是对于专业开发人员来说,这些“黑匣子”阻止了许多技术细节。作为开源解决方案,火山发动机的抹布图像使开发人员可以看到更多的基本细节,优化多个技术维度,从而创建真正的技术障碍。 DePseek受到欢迎后,许多公司计划在当地部署。市场上有许多解决方案。一张通常有八张高性能图形卡。该解决方案的成本不低。在满足您的商业需求之前,投资数十万美元可能并不明智。现在,用户可以在3分钟内创建一个开发环境,并开始各种学习和实用。为了帮助开发人员提高其功能,英特尔已经准备好了ED一系列课程,以帮助每个人补充相关知识,并从0到1迈出第一步,并为数据奠定坚实的基础。基金会是一个硬件平台,是大型模型应用程序开发的三个要素,而英特尔专家总结了大型模型应用程序开发的三个要素。除了支持和软件电池指南课程以及对当前提到的指导课程的支持外,硬件环境也很重要。火山引擎基于Intel Xeon处理器建造各种云主机。通常,最近基于Intel Xeon 6收益处理器的G4IL通常宣布的示例非常适合开发大型应用程序。 。 G4IL是第四代火山发动机的通用示例,其中“ G”代表通用,“ 4”代表第四代,“ I”代表Intel CPU平台。与第三代,在数据库,Web应用程序和图像表示的应用中,其一般性能都得到了显着提高,并且它们在AI的推论中的优势尤其值得注意。多亏了集成的AMX加速器,Intel Xeon 6处理器已成为AI推理的最佳X86架构处理器之一。在火山引擎的G4IL实例中,用户可以使用CPU完成AI的推断。与基于GPU的解决方案相比,它具有较低的成本和更容易资源的收购的优势,这使您可以满足基本需求。基于CPU的推理溶液特别适合于IA的LAS应用的开发和验证阶段。火山引擎抹布镜的前部使用户可以快速为大型云应用程序构建开发环境,从而大大降低了硬件资源阈值。当涉及生产过程时,您通常会陷入困境d使用CPU + GPU的非均匀计算机架构。例如,具有AMXLAS CPU N的XEO可用于处理轻巧的负载,例如嵌入,共振和矢量数据库,从而使GPU专注于处理重载,改善资源的使用和一般处理能力。 G4IL的亮点是,用户可以无需使用GPU执行使用7或14B参数的Distilled DeepSeek版本模型,只需选择配备16个VCPU或32 VCPU的云主机即可。还值得一提的是,该解决方案还支持DePseek建议的高精度计算格式BF16,从而进一步提高了推理质量。摘要:在技术发展快速发展的云平台的帮助下,它不仅降低了测试和错误成本,而且还可以加速创新,并为公司和开发人员提供灵活的选择。更重要的是,改进布和其他技术可以创建AI不能“限制”大型模型的应用程序。

从2025年开始,AI模型的容量仍在迅速提高。注意这一领域表明,许多企业家花费了大量的精力创建AI应用程序,但是通常会迅速被新一代最大模型的“本地特征”取代。这种类型的应用程序被归类为快速软件包层(提示单词)。这些应用程序调用了大型模型的基本功能,该功能迅速设计单词,但不会创造更深的商业价值。很容易替换一个始终更强的大型模型,因为应用程序的值主要取决于最大模型的原始功能。如何开发不容易被大型模型“移动”的AI应用程序?从这个意义上讲,英特尔的技术专家认为,大型模型应用程序的开发可以轻松地作为大型模型的功能,因为它们需要基于大型模型的代理的直接开发,而不仅要扩展大型模型的功能。大型模型应用程序的开发必须从不好或无法克服大型模型的点开始,例如解决数据库问题。当前大型模型中,两个最明显的问题与数据有关。忍受的第一件事是幻觉。大型模型基本上执行随机操作。它发生的内容越多,概率偏差就越大。此外,数据质量培训可能导致幻觉。需要进行基本的技术变革,以完全消除短期幻想的问题。其次,我们无法实时更新我们对出色模型的知识。大型模型的前游泳大约几个月前有固定的时间,他不知道发生了什么,他无法按时更新他的知识基础。所做的答案仅基于已知的旧内容。为了应对这两个主要问题,该行业是要达成共识并建立抹布 - 底座D知识库(搜索改进)。根据大型且先前训练的模型连接外部数据源。所有任务和答案都是从知识库中提取的,然后最大的模型响应。在某些操作中,公司必须将内部文档转换为机器格式。该文档首先进行分割,然后对矢量进行分割,并最终保存在矢量数据库中。当用户调用问题时,问题将变成矢量,具体取决于它们,并在矢量数据库中寻求,并根据最终恢复的内容生成答案。在生成答案时,记忆和精度是概念重要的ICA。在内存中,让我们看看他们恢复了多少个“真正相关”的文档。精确度的是,寻求的文件数量“真的很重要”。英特尔专家说,在查看这些技术细节时,应该指出的是,大型模型的影响受到太多因素和链接的影响。例如,选择一个i将文本转换为文档大小,恢复数据等的媒介,段等的NTEGRY模型会影响最终一代的结果。在英特尔的专家意见中,制作出色的模型开发可能不是直接从代理商开始的最喜欢的方法。基于小数据的差异可能会恶化最终效果。换句话说,如果您可以处理数据本身,则它变得更加不可替代,而不是仅依赖于最大模型的性能。立即开始并创建云中业务层面的无效开发环境。如今,许多大型国家和外国公司都基于大型语言模型和破布技术建立业务知识,许多前线员工得到了高度认可。由于RAG的知识库对公司非常重要,因此火山引擎已经推出了云的镜子,以接纳RAG场景。火山引擎在模型服务的大领域非常有效。根据启动IDC“对中国公共云模型模型模型的结构,报告1T25”,火山发动机在2024年首次在呼叫市场中首次分类。火山发动机是火山弧是一种火山弧,只有大型模型服务平台,例如Cozeesarials De Hyagent。新推出的抹布镜使常规开发人员可以轻松地开发具有较大阈值模型的“联合限制”应用程序。抹布图像不仅包含集成的模块,还包括向量数据库,重读模型和7B DeepSeek蒸馏模型。它提供数据包皮,模块和前端页面来处理在线问答服务,并且所有软件电池均已预先优化。作为面向公司的服务,火山引擎的抹布图像是指OPEA Architecture。 OPEA是去年Intel推出的开源社区,使用开放式体系结构和模块化组件来帮助公司构建可扩展的AI应用程序NS实施基础。与普通的开源体系结构相比,火山发动机图像具有更多的业务水平。许多云制造商还为普通用户提供较低阈值的抹布服务,但是对于专业开发人员来说,这些“黑匣子”阻止了许多技术细节。作为开源解决方案,火山发动机的抹布图像使开发人员可以看到更多的基本细节,优化多个技术维度,从而创建真正的技术障碍。 DePseek受到欢迎后,许多公司计划在当地部署。市场上有许多解决方案。一张通常有八张高性能图形卡。该解决方案的成本不低。在满足您的商业需求之前,投资数十万美元可能并不明智。现在,用户可以在3分钟内创建一个开发环境,并开始各种学习和实用。为了帮助开发人员提高其功能,英特尔已经准备好了ED一系列课程,以帮助每个人补充相关知识,并从0到1迈出第一步,并为数据奠定坚实的基础。基金会是一个硬件平台,是大型模型应用程序开发的三个要素,而英特尔专家总结了大型模型应用程序开发的三个要素。除了支持和软件电池指南课程以及对当前提到的指导课程的支持外,硬件环境也很重要。火山引擎基于Intel Xeon处理器建造各种云主机。通常,最近基于Intel Xeon 6收益处理器的G4IL通常宣布的示例非常适合开发大型应用程序。 。 G4IL是第四代火山发动机的通用示例,其中“ G”代表通用,“ 4”代表第四代,“ I”代表Intel CPU平台。与第三代,在数据库,Web应用程序和图像表示的应用中,其一般性能都得到了显着提高,并且它们在AI的推论中的优势尤其值得注意。多亏了集成的AMX加速器,Intel Xeon 6处理器已成为AI推理的最佳X86架构处理器之一。在火山引擎的G4IL实例中,用户可以使用CPU完成AI的推断。与基于GPU的解决方案相比,它具有较低的成本和更容易资源的收购的优势,这使您可以满足基本需求。基于CPU的推理溶液特别适合于IA的LAS应用的开发和验证阶段。火山引擎抹布镜的前部使用户可以快速为大型云应用程序构建开发环境,从而大大降低了硬件资源阈值。当涉及生产过程时,您通常会陷入困境d使用CPU + GPU的非均匀计算机架构。例如,具有AMXLAS CPU N的XEO可用于处理轻巧的负载,例如嵌入,共振和矢量数据库,从而使GPU专注于处理重载,改善资源的使用和一般处理能力。 G4IL的亮点是,用户可以无需使用GPU执行使用7或14B参数的Distilled DeepSeek版本模型,只需选择配备16个VCPU或32 VCPU的云主机即可。还值得一提的是,该解决方案还支持DePseek建议的高精度计算格式BF16,从而进一步提高了推理质量。摘要:在技术发展快速发展的云平台的帮助下,它不仅降低了测试和错误成本,而且还可以加速创新,并为公司和开发人员提供灵活的选择。更重要的是,改进布和其他技术可以创建AI不能“限制”大型模型的应用程序。 下一篇:没有了